Debido a que estos sistemas aprenden a partir de muchos más datos de los que los humanos podríamos llegar a comprender, ni siquiera los expertos en inteligencia artificial pueden entender por qué generan un texto en particular en un momento determinado.

SAN FRANCISCO — Este mes, cuando Microsoft agregó un chatbot a Bing, su motor de búsqueda, la gente se dio cuenta de que ofrecía todo tipo de información falsa sobre Gap, la vida nocturna mexicana y la cantante Billie Eilish.

Luego, cuando periodistas y otros de los primeros usuarios de prueba entablaron largas conversaciones con el bot de inteligencia artificial de Microsoft, este comenzó a mostrar un comportamiento grosero y perturbador.

En los días que han pasado desde que la conducta del bot de Bing se convirtió en una sensación mundial, a la gente le ha costado comprender la rareza de esta nueva creación. La mayoría de las veces, los científicos han afirmado que buena parte de la culpa recae en los humanos.

Sin embargo, sigue habiendo cierto misterio en torno a lo que puede hacer el nuevo chatbot y su motivación para hacerlo. Su complejidad lo vuelve difícil de diseccionar y todavía más difícil de predecir, además de que los investigadores lo están analizando a través de una lente filosófica y conforme al código duro de las ciencias de la computación.

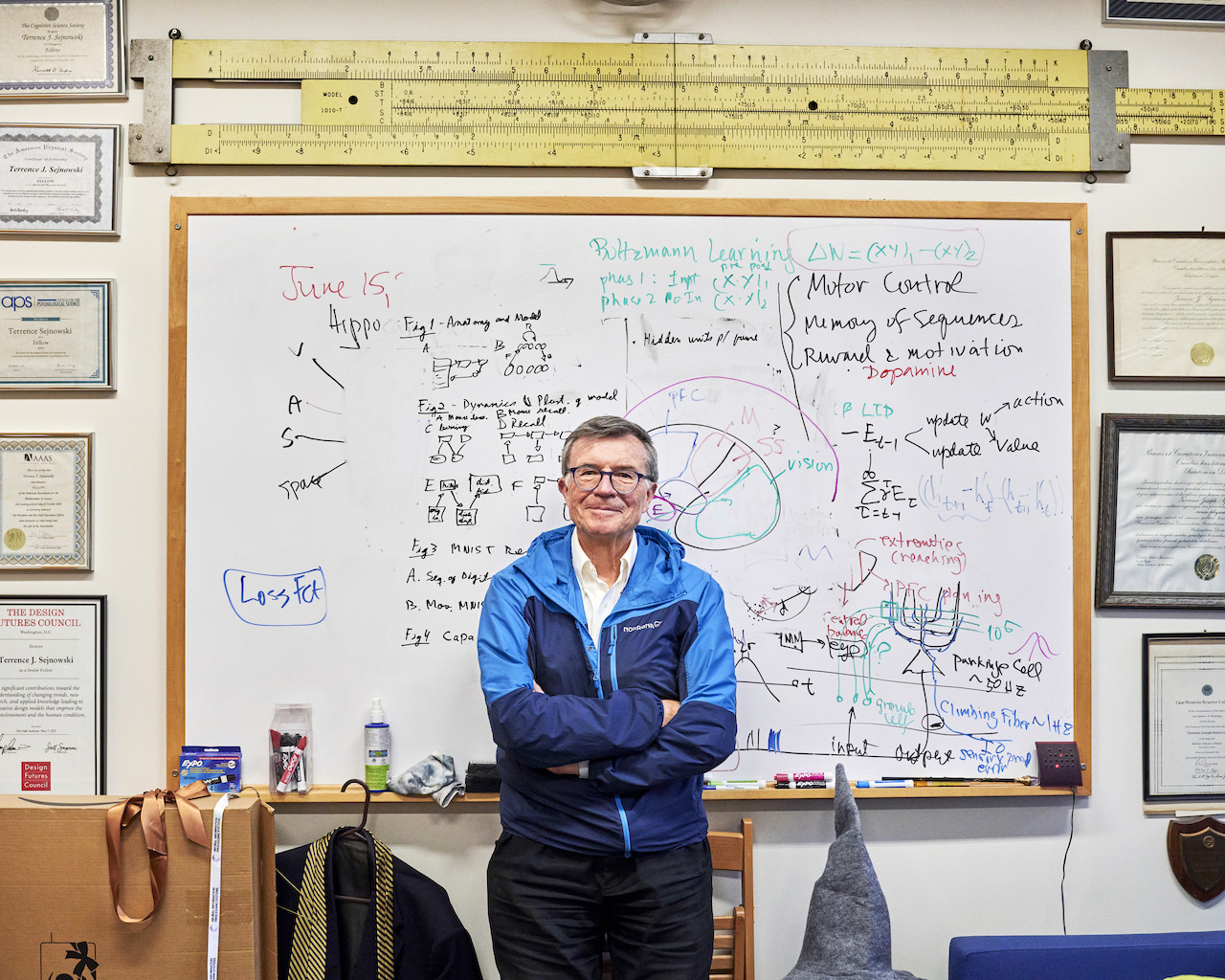

Como cualquier otro estudiante, un sistema de inteligencia artificial puede aprender mala información de malas fuentes. ¿Y ese extraño comportamiento? Puede ser el reflejo distorsionado que hace un chatbot de las palabras e intenciones de las personas que lo utilizan, comentó Terry Sejnowski, neurocientífico, psicólogo y especialista en computación que ayudó a sentar las bases intelectuales y técnicas de la inteligencia artificial moderna.

“Esto ocurre cuando profundizas cada vez más en estos sistemas”, explicó Sejnowski, profesor del Instituto Salk de Estudios Biológicos y la Universidad de California, campus San Diego, quien este mes publicó un trabajo de investigación sobre este fenómeno en la revista científica Neural Computation. “Busques lo que busques, —desees lo que desees—, te lo darán”.

Este mes, Google también presumió un nuevo chatbot, Bard, pero los científicos y periodistas se dieron cuenta de inmediato de que escribía disparates sobre el Telescopio Espacial James Webb. OpenAI, una empresa emergente de San Francisco, inició el auge de los chatbots en noviembre cuando presentó ChatGPT, un bot que tampoco dice siempre la verdad.

Los nuevos chatbots tienen como base una tecnología que los científicos llaman “gran modelo de lenguaje” (LLM, por su sigla en inglés). Estos sistemas aprenden analizando enormes cantidades de texto digital extraído del internet, que incluye volúmenes de material falso, tendencioso y, por lo demás, tóxico. El texto del que aprenden los chatbots también está un poco pasado de moda, porque deben analizarlo durante meses antes de que el público pueda utilizarlos.

Mientras analiza ese mar de información buena y mala de todo el internet, un LLM aprende a hacer una cosa en particular: adivinar la siguiente palabra de una secuencia de palabras.

Funciona como una versión gigante de la tecnología de autocompletar que te sugiere la siguiente palabra cuando escribes un correo electrónico o un mensaje instantáneo en tu teléfono inteligente. En la secuencia “Tom Cruise es un ____”, podría adivinar “actor”.

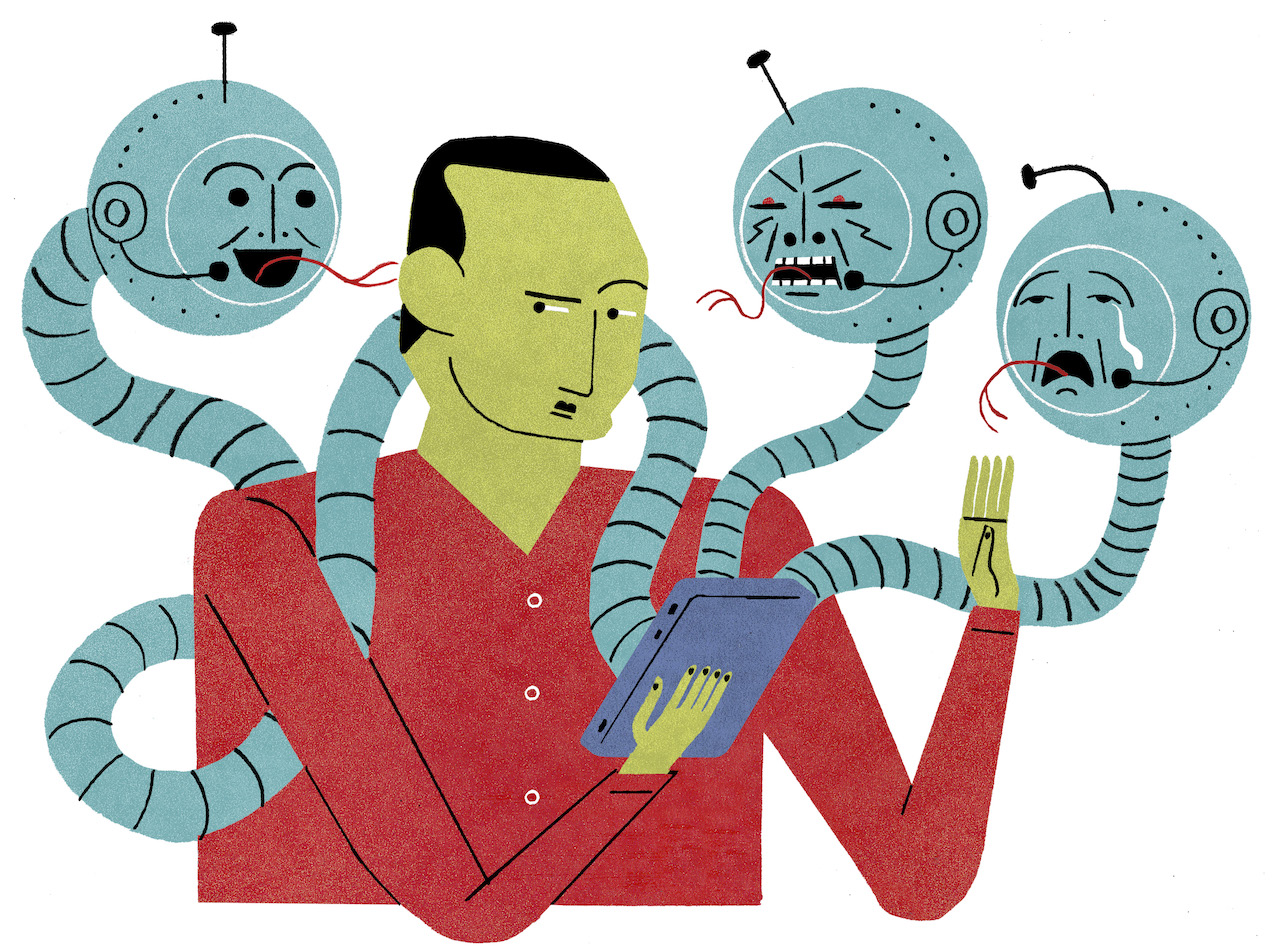

Cuando conversas con un chatbot, este no solo recurre a todo lo que ha aprendido del internet. Utiliza todo lo que tú le has dicho y todo lo que te ha respondido. No solo adivina la siguiente palabra de su oración. Está adivinando la siguiente palabra del largo bloque de texto que incluye tanto tus palabras como las suyas.

Mientras más larga se vuelve la conversación, mayor la influencia que tiene el usuario sobre lo que dice el chatbot sin saberlo. Si quieres que se enoje, se enoja, comentó Sejnowski. Si lo persuades para que se ponga raro, se pone raro.

Microsoft y OpenAI han decidido que la única manera de averiguar qué harán los chatbots en el mundo real es darles rienda suelta… y contenerlos cuando divaguen. Ambas compañías creen que su gran experimento público vale la pena el riesgo.

Sejnowski comparó el comportamiento del chatbot de Microsoft con el Espejo de Oesed, un artefacto místico de las novelas de “Harry Potter” de J. K. Rowling y muchas de las películas basadas en su mundo ingenioso de jóvenes magos.

“Oesed” es “deseo” al revés. Cuando la gente descubre el espejo, parece darle verdad y comprensión. Sin embargo, no es así. Muestra los deseos más profundos de cualquiera que vea su reflejo en él. Y algunas personas se vuelven locas si lo miran demasiado tiempo.

“Debido a que los humanos y los LLM se reflejan entre sí, con el tiempo tenderán hacia un estado conceptual común”, explicó Sejnowski.

Según Sejnowski, no debería sorprendernos que los periodistas hubieran empezado a ver un comportamiento extraño en el chatbot de Bing. De modo consciente o inconsciente, estaban empujando al sistema en una dirección incómoda. A medida que los chatbots asimilan nuestras palabras y nos las devuelven, pueden reforzar y amplificar nuestras creencias y convencernos de creer en lo que nos dicen.

Debido a que estos sistemas aprenden a partir de muchos más datos de los que los humanos podríamos llegar a comprender, ni siquiera los expertos en inteligencia artificial pueden entender por qué generan un texto en particular en un momento determinado.

Sejnowski comentó que cree que, a largo plazo, los nuevos chatbots tendrán la capacidad de aumentar la eficacia de las personas y ofrecerles maneras para realizar tareas mejor y más rápido. No obstante, hay una advertencia tanto para las empresas que construyen estos chatbots como para las personas que los utilizan: también pueden alejarnos de la verdad y llevarnos a lugares oscuros.

“Este es un terreno inexplorado”, mencionó Sejnowski. “Los humanos nunca lo habían experimentado”.